„Die wichtigste Maßnahme zur Absicherung gegen Ransomware-Angriffe besteht in funktionierenden Backups.” (1) Und Backups schützen Daten nicht nur vor Ransomware und anderer Malware, sondern auch vor Datenverlust, Ausfällen durch versehentliches oder auch böswilliges Löschen, Hardware-Defekten und anderen Katastrophen wie Brand und Überschwemmung.

Aber was macht ein funktionierendes, also ein gutes Backup aus?

Backup ist nicht gleich Backup. Viele Nutzer wiegen sich immer noch zu oft in falscher Sicherheit. Backups sind zwar kein Hexenwerk, trotzdem gibt es ein paar Punkte, die Nutzer und Administratoren beachten müssen, damit aus einer Datensicherung ein gutes Backup wird und Einsparpotenziale erkannt werden.

Ein gutes Backup sollte grundsätzlich diese 4 Eigenschaften mitbringen. Es sollte:

1. zuverlässig,

2. flexibel,

3. wartungsarm,

4. langfristig sein.

1. Ein gutes Backup ist zuverlässig

1.1. RPO und RTO

Hinsichtlich der Eigenschaft „Zuverlässigkeit“ sind zwei Fragen entscheidend:

-

Wie hoch darf der maximal hinnehmbare Datenverlust sein? Sprich wie hoch darf das RPO (Recovery Point Objective) sein?

-

Wie lange darf der Produktivitätsausfall andauern? Sprich wie hoch darf das RTO (Recovery Time Objective) sein?

Je höher der Datenverlust ist und je länger der Produktivitätsausfall dauert, sprich je höher das RPO und RTO sind, desto teurer wird es für Unternehmen. Das Ziel ist es also, ein Backup mit möglichst minimalen Kennzahlen zu wählen.

Jedoch wird insbesondere die 2. Frage – das RTO – oft unterschätzt. Immer noch testen einige Unternehmen die Wiederherstellung von Dateien nicht. Dabei ist diese Überprüfung jedoch äußerst wichtig. Einerseits ermöglicht sie es, im Fall einer Katastrophe angemessen vorbereitet zu sein und entsprechend zu handeln. Andererseits liefert sie wertvolle Erkenntnisse darüber, wie lange es dauern wird, die Systeme wiederherzustellen – sei es in wenigen Minuten, Stunden oder sogar Tagen. Diese Informationen sind entscheidend, um einzuschätzen, wie lange die Produktivität beeinträchtigt sein wird und welche Auswirkungen auf die Arbeit zu erwarten sind.

1.2. Zuverlässiges Backup mit der 3-2-1 Regel?

Die volle Zuverlässigkeit erreicht eine Backup-Lösung nur, wenn sie in einer ganzheitlichen Strategie richtig eingesetzt wird. Um das zu erreichen, hilft die 3-2-1 Backup-Regel. Diese kurze Faustformel besagt, dass:

- mindestens drei (3) Backup-Kopien erstellt werden sollen,

- wobei diese Kopien auf mindestens zwei (2) verschiedenen Datenträgern gespeichert werden sollten,

- von denen sich mindestens einer (1) an einem separaten Standort befinden soll.

Bei der 3-2-1 Regel geht es jedoch primär darum, das RPO einzuhalten, sprich den Datenverlust im Katastrophenfall zu minimieren.

Bezüglich des RTOs, also der Zeit zurück zur Produktivität, hilft die 3-2-1 Regel hingegen nicht. Deshalb werden zusätzlich zu dieser Faustformel auch noch zuverlässige Wiederherstellungsoptionen benötigt. Dabei benötigen unterschiedliche Ausfallszenarien unterschiedliche Optionen.

1.3. 3 Wiederherstellungsoptionen für ein zuverlässiges Backup

Ein zuverlässiges Backup sollte folgende 3 Wiederherstellungsoptionen anbieten:

2. Ein gutes Backup ist flexibel

Ein gutes Backup sollte nicht nur zuverlässig, sondern auch flexibel sein, und das sowohl hinsichtlich der vorhandenen Backup-Ziele und -Quellen, sowie der aktuellen und zukünftigen Anwendungsgrößen.

Vor allem bei einer Neuanschaffung muss es möglich sein, die neue Backup-Lösung einfach in die bereits bestehenden Backup-Ziele und -Quellen zu integrieren. Heutzutage bestehen IT-Umgebungen meist aus drei Teilen: der externen Cloud, der internen IT (auf der produktiv gearbeitet wird) und dem Backup-Server bzw. dem eigenen Rechenzentrum bei größeren Unternehmen. In alle drei bereits bestehenden Teile muss sich eine neue Backup-Lösung flexibel eingliedern lassen.

Mit einer Flexibilität in Bezug auf die Backup-Ziele und -Quellen ist es aber noch nicht getan. Auch die Anwendungsgröße, sprich die flexible Skalierbarkeit, ist wichtig. Wenn sich ein Admin erst einmal an eine bestimmte Lösung gewöhnt hat, damit vertraut ist und auch bereits Probleme lösen kann, dann macht es keinen Sinn, in jeder Wachstumsphase eines aufstrebenden Unternehmens zu einer neuen Lösung zu greifen. Die gewählte Backup-Lösung sollte sich hingegen an wachsende IT-Infrastruktur und Datenmengen flexibel anpassen lassen.

3. Ein gutes Backup ist wartungsarm

Indem keine eigene Hardware gewartet werden muss, wird sowohl Zeit als auch Arbeitsaufwand eingespart. Das ist ein oft genannter Vorteil von Cloud-Backup-Lösungen. Aber ein lokales, privates on-premise Backup im eigenen Büro spart nicht nur Abo-Gebühren für den Cloud-Speicher, sondern kann ebenfalls sehr wartungsarm sein.

Die erste, unverzichtbare Erleichterung erlangen Admins durch sogenannte Masseninstallation („Mass Deployment“). Diese ist oft mit on-premise Lösungen möglich. Generell sollten nicht mehr als fünf Schritte nötig sein, um hunderte oder sogar tausende Rechner zu sichern. Der Aufwand sollte dabei unabhängig von der genauen Geräteanzahl sein.

Die Masseninstallation war auch ein wichtiger Grund, warum sich Shiseido Taiwan, ein globaler Marktführer im Kosmetikbereich, der bereits seit 148 Jahren im Geschäft ist, für die lokale Backup-Lösung von Synology entschied. In dem Unternehmen werden mehr als 500 PCs und 55 VMs betrieben und es finden täglich Datenänderungen von bis zu 600GB statt. 2017 kam es dort zu einem Ransomware-Angriff. Um sich vor diesem und weiteren Gefahren zukünftig zu schützen, wurde in wenigen Minuten eine Masseninstallation in folgenden Schritten durchgeführt:

- Konfiguration der MSI-Datei

- Ausspielung der MSI-Datei großflächig über die Domäne auf alle zu sichernden Geräte

- Neustart aller zu sichernden Geräte

Die benötigte Zeit für das Backup und der verwendete Speicherplatz wurden jeweils um circa 50% reduziert.

Da die gesamte Backup-Lösung (inkl. Software, Hardware, Support) aus einer Hand kommt, sinkt zudem der Wartungsaufwand. Damit sparen die Administratoren von Shiseido Taiwan im Notfall wertvolle Zeit, da sie nicht an unterschiedlichen Türen klopfen müssen und ggf. Zeit verlieren, weil sie die Problemquelle und damit den Ansprechpartner nicht eindeutig identifizieren können.

4. Ein gutes Backup ist langfristig

Das langfristige Ziel aller Unternehmen, wenn es um das Thema Backup geht, ist – neben Sicherheit – Effizienz. Es gilt also langfristig Zeit, Speicherplatz und Bandbreite zu sparen, um letztendlich Geld und emotionales Kapital (Nerven) der Mitarbeiter und Entscheider zu sparen. Lizenzkosten widersprechen diesem Ziel.

4.1. Langfristig effizient ohne Lizenzkosten

Lizenzkosten sind sowohl privat als auch im Unternehmensbereich schwer überblickbar und können schnell zu einer der größten Kostenstellen in der IT werden.

Wie stattdessen durch die Wahl der passenden Backup-Lösung signifikant Geld gespart werden kann, zeigt die Corin Group in Australien. Sie produziert Gelenkimplantate und Hörhilfen und nutzt mit über 2.400 Mitarbeitern Microsoft 365.

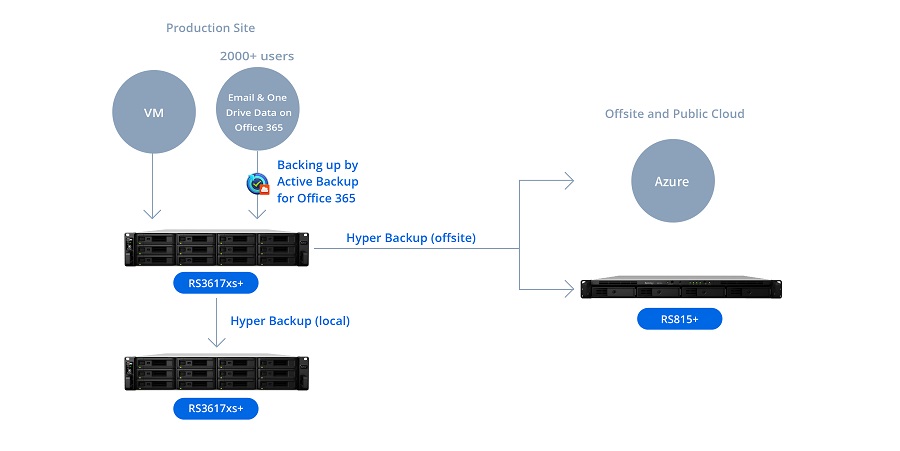

Doch Datenverluste in Public Clouds sind wahrscheinlicher als häufig vermutet. Die Hauptursachen sind dabei das versehentliche Überschreiben sowie das böswillige Löschen durch Mitarbeiter ebenso wie das böswillige Löschen durch Hacker. Um diese Risiken zu minimieren, sollten also die täglich anfallenden Daten noch einmal lokal im eigenen Büro gesichert werden. Die Corin Group entscheid sich dabei für die Hardware und die integrierte lizenzfreie Backup-Software Active Backup for Business von Synology. Mit der neuen Infrastruktur (siehe Abbildung unten) sparen sie heute rund 4.000€ pro Monat an Lizenzgebühren.

Das Unternehmen tätigte nur eine einmalige Hardware-Anschaffung, da bei der Backup-Lösung von Synology keine Lizenzgebühren für die Software anfallen, womit komplizierte, unüberschaubare Abonnements ebenfalls wegfallen. Das ermöglicht nicht nur höhere Gewinne, sondern auch eine grundsätzlich gesteigerte Unabhängigkeit vom Microsoft-Riesen. Ein Backup zu viel ist immer besser als eines zu wenig.

4.2. Speicherplatz und Bandbreite langfristig einsparen

Beim Thema Langfristigkeit gilt es aber nicht nur Lizenzen einzusparen. Auch jeder belegte Megabyte an Speicherplatz und Bandbreite ist bare Münze wert. Dementsprechend sind automatische Aussortierungsmechanismen, wie Deduplizierung, Changed Block Tracking (CBT) und Snapshots, nötig.

4.3. Mehr Effizienz durch langfristige Geschäftsbeziehungen

Langfristige Geschäftsbeziehungen sind immer gut. Deshalb bietet Synology seinen Partnern Schulungen, Projektschutz, stark rabattierte Hardware, persönliche Ansprechpartner und viele weitere Vorteile an. Die meisten Neukunden sind zudem immer noch von der umfangreichen Software überrascht, welche so viel mehr Möglichkeiten als Backups bietet und den ROI der IT-Investition weiter maximiert.

Sie suchen eine gute Backup-Lösung für Ihr Unternehmen? Lassen Sie sich unverbindlich von Experten beraten.